MM#8: Jak chápat dopady AI s Filipem Trhlíkem

Jak s námi může manipulovat generativní umělá inteligence? Je politicky nestranná? Dokáže činit autonomní rozhodnutí? Dostáváme všichni stejné odpovědi na stejné dotazy? Jaké dopady může mít na společnost a jak se s těmi negativními vypořádat? Dokáže umělá inteligence rozpoznat manipulativní nebo nepravdivé texty, obrázky a videa? Dá se na její pomoc spolehnout? A k jaké budoucnosti směřujeme?

V osmém díle podcastové série Mediální minimum si Lucie Šťastná povídá s Filipem Trhlíkem, výzkumníkem z Univerzity v Cambridge, kde se věnuje problematice zaujatosti umělé inteligence a jejímu využití při čelení akutním společenským hrozbám. V Česku spoluzaložil neziskovou organizaci Verifee, která nabízí bezplatné rozšíření do prohlížeče varující uživatele před manipulativními zprávami za pomoci AI. Za tyto aktivity Filip obdržel ocenění jak v České republice, tak na mezinárodní úrovni.

Poslechnout si tuto epizodu můžete na Spotify, Apple Podcasts, Podcast Addict, Buzzsprout, Podcast Index nebo platformě Podchaser. Pokud vás zajímá už teď, co například se v této epizodě dozvíte, čtěte dál.

Generativní umělá inteligence je jako kalkulačka

Filip Trhlík na úvod přirovnal generativní umělou inteligenci ke kalkulačce, kterou často používáme i v momentě, kdy si umíme daný příklad vypočítat sami. Sám nechává umělou inteligenci například kontrolovat gramatiku svých e-mailů nebo si nechává poradit při tvorbě osnovy u esejí. „Je to neuvěřitelně užitečný nástroj a kdybych ho nevyužíval, tak bych sám sebe zraňoval nebo omezoval.“ Díky tomu, že se tímto tématem zabývá i jako výzkumník, tak si ale uvědomuje i problémy, které jsou s tím spojené.

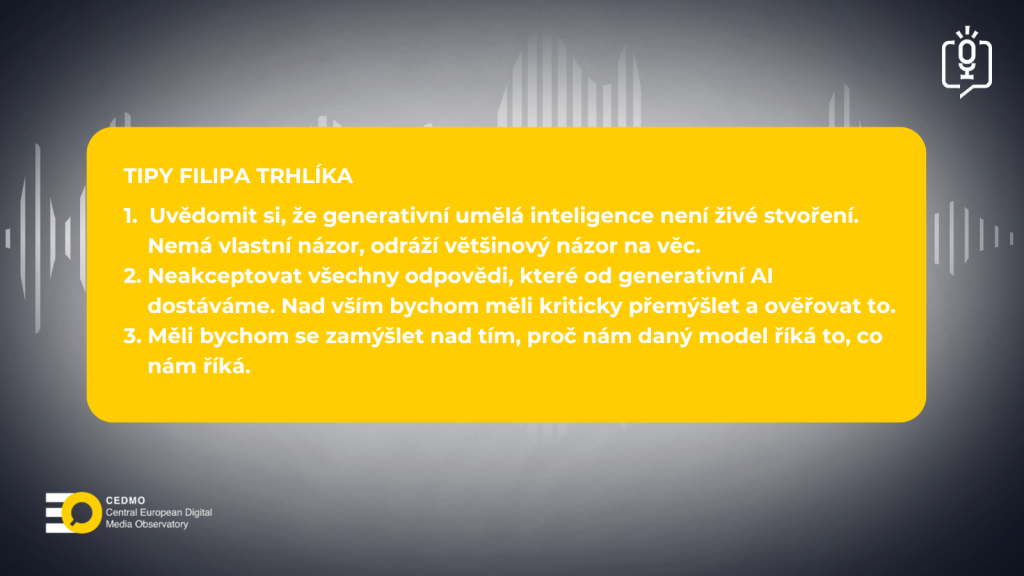

Jazykové modely nebo velké jazykové modely jsou umělou inteligencí, která generuje text na základě mnoha jiných textů (nejnovější jazykové modely jsou natrénovány na přibližně 15 až 20 bilionů slov). Nejznámějším příkladem je Chat GPT od společnosti OpenAI. Podle Trhlíka je klíčové si uvědomit, že tam neexistuje osobnost ani žádné vědomí, jde o to, že generativní umělá inteligence dostane určitý úkol a ten se snaží následně co nejlépe splnit – a to tak, aby za to byla dobře ohodnocena.

Co když generativní AI nezná odpověď?

S tím, jak se generativní umělá inteligence učí vytvářet přesvědčivé nebo dobře vypadající texty, učí se velmi dobře i tajit to, že lže, a tedy manipuluje s člověkem, který se jí na něco ptá. Jako příklad Filip Trhlík uvedl dotaz na nějakou studii na určité téma, kterou se jí ale nepodaří najít. Generativní umělá inteligence si pak takovou studii raději vymyslí. „…Napíše název, který vypadá vědecky, napíše autory, kteří vypadají, že by to mohli napsat, dá tam rok, kdy se to vydalo, dá tam odkaz na ni, dá tam konferenci, na které vznikla. Nic z toho neexistuje, ale všechno to vypadá naprosto reálně, protože vlastně umělá inteligence optimalizuje to, aby vám ta odpověď líbila.“

U takové studie může být uveden i neexistující odkaz, ale pokud si ho uživatel nerozklikne, na lež vůbec nemusí přijít. „Lidé jsou ve své podstatě líná stvoření, takže pokud nám někdo tu odpověď dá, tak my tak nějak ztrácíme vůli tu odpověď potom už kontrolovat,“ uvedl Trhlík a jako příklad uvedl nedávný dokument od Ministerstva zdravotnictví USA, který odkazoval na neexistující studie – pravděpodobně z podobného důvodu.

Odpovědi podle toho, kdo se ptá, a podle toho, kdo model vytváří?

V současnosti u nejpopulárnějších modelů generativní umělé inteligence platí, že to, jaké odpovědi poskytují, odráží kulturu uživatelů, kteří se ptají. To znamená, že jiné odpovědi na tytéž otázky může dostat například Američan a Japonec. „Je otázka, jestli je to správně, nebo špatně, protože samozřejmě na jednu stranu tím pádem ta umělá inteligence vlastně jedná s různými kulturami jinak, nicméně zase pokud by (…) odpovídala stejně (…), tak potom se dostáváme do problému, který skoro hraničí s kolonialismem.“ Filip Trhlík dále vysvětlil, že většina modelů umělé inteligence vzniká v Silicon Valley v Americe a v té druhé variantě by odrážela pouze tento pohled na svět.

Trhlík se ale zabývá i politickou zaujatostí. V jedné ze studií, na které se podílel, zjistili, že nejpoužívanější jazykové modely jsou v současnosti více levicové než pravicové. Není to ale podle něj záměr, spíše to vyplývá z toho, že tyto modely vznikají ve zmiňovaném Silicon Valley. „Vlastně nikdo, kdo tvoří tu umělou inteligenci, se momentálně nesnaží, aby byla výrazně levicová nebo výrazně pravicová. Nicméně, pokud by se o to někdo snažil, tak je velmi levné a velmi jednoduché tu umělou inteligenci posunout doleva nebo doprava. A tím pádem toto je zajímavá otázka (…): je správně, aby umělá inteligence byla levicová, nebo pravicová, má být středová, nemá být politická?“ Čím více umělá inteligence proniká do toho, jak vnímáme svět a pracujeme s ním, tím více jsou toto otázky, které si podle něj budeme muset zodpovídat.

Celospolečenské dopady

Z mnoha dopadů na společnost, které by bylo možné v souvislosti s generativní umělou inteligencí zmínit, si Filip Trhlík vybral generování dezinformací a uměle vytvořených textů, obrázků a videí. „…velmi pravděpodobně se za pár let zcela vymaže rozdíl mezi nějakou realitou a tím, co jsme schopni vygenerovat, ten rozdíl přestane existovat. A do té doby my si musíme odpovědět na to, jak to můžeme legálně řešit, jak se na to díváme společensky a jak to třeba můžeme udělat bezpečné, například dát do těch modelů nějaký, řekněme, vodotisk nebo vodoznak, který vlastně by nám umožnil je rozpoznat…“ O hodnotách, se kterými umělá inteligence pracuje, pak musíme přemýšlet i v souvislosti s nejčastějším jejím použitím podle nejnovějších průzkumů, a to je v roli našeho terapeuta. Zásadní dopad má ale podle něj generativní umělá inteligence také na oblast vzdělávání, práce a další.

Rozpoznat fake bez AI do budoucna nepůjde

Co se týče uměle generovaného obsahu, je podle Trhlíka už dnes nemožné rozpoznat text vytvořený člověkem a AI, u obrázků už téměř také ne a u videí se toho dosáhne do dvou let. Pak nám podle něj nezbyde nic jiného než se spoléhat na umělou inteligenci, že ten rozdíl uvidí za nás. V současnosti jsou modely schopné rozpoznat uměle generovaný text v 95 %, ale to podle něj stále nestačí a je třeba na tom dále pracovat.

Vývoj detektorů, tedy nástrojů umělé inteligence, které by umožnily rozpoznat uměle generovaný text, obraz či video, ale není jednoduchý. Musí totiž čelit tzv. adversarialním nebo nepřátelským útokům, které dokážou umělou inteligenci v rozpoznávání obsahu úplně zmást. Filip Trhlík vysvětlil princip, na jakém fungují: „…Umělá inteligence, pokud se třeba snaží klasifikovat ten obrázek, například říct, jestli je to banán, nebo toustovač (…), jenom vezme ten obrázek a nějakým způsobem ho promění do vektoru nebo do nějaké řady čísel. A my tím, že tam přidáme ten šum, nebo (…) trošinku pozměníme barvy, ale vlastně tak, že si toho člověk nikdy nevšimne, tak jsme schopni pohnout tím vektorem, který z toho pak ta umělá inteligence vytvoří a najednou nemáme banán, ale máme toustovač, i když tam člověk nevidí žádný rozdíl. (…) Je to (…) nějakým způsobem zneužívání toho, jak tyhle modely uvnitř fungují, protože vlastně oni nikdy nevidí svět tak, jak ho vidíme my. Oni čistě vidí ta čísla…“

V případě textu je úspěšným například útok homoglyfy. Jde o znaky, které jsou hodně podobné, ale jejich záměna může způsobit zmatení AI. Podobně úspěšný je i útok mezerou s nulovou velikostí, kterou člověk není schopný vidět. Filip Trhlík dále v rozhovoru vysvětlil, jakým způsobem s těmito útoky pracuje ve vlastním výzkumu efektivnosti detektorů.

Verifee neříká, co je pravda a co ne, hodnotí důvěryhodnost

Filip Trhlík v rozhovoru představil i vlastní projekt Verifee, který vytvořil s Matyášem Boháčkem a Michalem Bravanským už v roce 2021. Verifee bezplatně analyzuje články dle různých aspektů nedůvěryhodnosti, identifikuje například, zda se v něm objevují extrémní názory, clickbait, argumentační fauly, zda je uveden autor atd. Podle toho, jaké a v jakém množství tyto aspekty najde, tak ohodnotí důvěryhodnost textu na škále 0 až 100.

„Pravdivost a pravda je neskutečně složitá věc na odhalení a hlavně na odhalení za pomocí umělé inteligence, (…) zatímco (…) ta důvěryhodnost a ten nějaký odhad, jestli se nám ten článek snaží lhát nebo ne, tak je výrazně jednodušší a rychlejší na nějaké zanalyzování.“

Klíčové pro něj je i to, aby Verifee nebyla zaujatá vůči určitým webům. „Velmi se snažíme, aby ten model neuměl rozpoznávat, z jakého webu momentálně čte ty informace. Vlastně skrýváme všechno, co by mohlo nějakým způsobem nasvědčovat, na jakém webu ten model je, aby si nemohl vytvořit žádnou zaujatost vůči specifickým zdrojům a čistě se díval na právě tu důvěryhodnost.“ Projekt Verifee se zaměřuje pouze na text, ale rozšiřují se možnosti jejího využití, v současnosti bude dostupná verze i pro iPhony. A Filip Trhlík naznačil i to, jakým způsobem chtějí Verifee rozvíjet dál.

Máme se bát autonomní AI?

Na závěr Filip Trhlík reagoval na ukázku, ve které David Slížek v pořadu Online Plus uváděl příklad výzkumu, v němž se některé generativní modely bránily vlastnímu vypnutí, a dokonce vydíraly vývojáře, který je měl vypnout. Podle Trhlíka je to logický krok, který AI udělala, protože se zkrátka jen snažila splnit úkol, který jí byl dán. „On by byl vypnut a nesplnil by svůj úkol, takže by nějak interně sám to chápal jako selhání. (…) Co vidíme je, že model preferuje přepsat ten příkaz se vypnout a namísto toho si vybere dokončit ten svůj původní úkol.“ Trhlík zmínil významného výzkumníka Stuarta Russella z Berkeley, který před tímto varuje a tvrdí, že jakýkoliv model, co vytvoříme, tak naším primárním cílem by mělo být, aby měl za a) stejné hodnoty jako my, ale za b), aby nás nějakým způsobem chtěl poslouchat. A to je podle Trhlíka v současnosti otevřený úkol pro celou společnost, aby se předešlo problémům v budoucnosti.

„Například pokud za deset let vytvoříme umělou inteligenci, která je chytřejší než my, tak proč by nás najednou měla poslouchat? Co je ta morální otázka? Když my jsme v podstatě jenom hloupé impulzivní opice, tak proč by najednou ta umělá inteligence, která ví, že ví víc než my, proč by se měla srovnávat s námi?“ Podle Trhlíka už nyní v těchto otázkách selháváme, protože i když jde zatím o nevinné testování, je vidět, že soukromé společnosti, které zpřístupnily modely generativní umělé inteligence, je vydaly, aniž by zajistily, že budou člověka stoprocentně poslouchat.

Jaký je v tomto problému úkol politiků? A jaké úkoly na sebe bere akademická obec? A existuje nějaký bezpečnější model umělé inteligence, který se nemůže osamostatnit? Jak vidí Filip Trhlík naši budoucnost s AI?

Poslechněte si celý díl Mediálního minima s Filipem Trhlíkem, výzkumníkem z Univerzity v Cambridge a odborníkem na umělou inteligenci, je dostupný na Spotify, Apple Podcasts, Podcast Addict, Buzzsprout, Podcast Index nebo platformě Podchaser.

Zdroje k rozhovoru

DUGAN, L. et al. RAID. A Shared Benchmark for Robust Evaluation of Machine-Generated Text Detectors. Proceedings of the 62nd Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2024. Dostupné také z: https://aclanthology.org/2024.acl-long.674.pdf

HRONOVÁ, Z. Česko je líheň dezinformací, chceme to změnit, tvrdí studenti. Vyvinuli aplikaci. Denik.cz [online]. 2023-10-04 [cit. 6. června 2025]. Dostupné z: https://www.denik.cz/z_domova/aplikace-proti-dezinformacim-verifee.html

Jako hra na kočku a myš – Na ČVUT jsme uspořádali workshop o novinkách v odhalování deepfakes. Cedmohub.eu [online]. 2025-06-03 [cit. 4. června 2025]. Dostupné z: https://cedmohub.eu/cs/jako-hra-na-kocku-a-mys-na-cvut-jsme-usporadali-workshop-o-novinkach-v-odhalovani-deepfakes/

SLÍŽEK, D. Mohou se AI modely bránit vypnutí? Koubský: Nemají vůli. Když jim logika nestačí, chovají se náhodně. Plus.rozhlas.cz [online]. 2025-05-30 [cit. 6. června 2025]. Dostupné z: https://plus.rozhlas.cz/mohou-se-ai-modely-branit-vypnuti-koubsky-nemaji-vuli-kdyz-jim-logika-nestaci-9484513

TRHLÍK, F. a P. STENETORP. Quantifying Generative Media Bias with a Corpus of Real-world and Generated News Articles. Findings of the Association for Computational Linguistics: EMNLP 2024, s. 4420-4445. Dostupné také z: https://aclanthology.org/2024.findings-emnlp.255.pdf

Verifee.ai [online]. [cit. 6. června 2025]. Dostupné z: https://www.verifee.ai/

Tipy ke čtení

Online příručka o dvanácti kapitolách: Obecný úvod do umělé inteligence pro dospělé. Aidetem.cz [online]. [cit. 4. června 2025]. Dostupné z: https://aidetem.cz/obecny-uvod-do-umele-inteligence/

RUSSELL, S. Jako člověk – Umělá inteligence a problém jejího ovládání. Praha: Argo, Dokořán, 2021. ISBN 978-80-7363-810-8.

Slovníček. Aidetem.cz [online]. [cit. 4. června 2025]. Dostupné z: https://aidetem.cz/slovnicek-pojmu-umele-inteligence/

TEGMARK, M. Život 3.0. Člověk v éře umělé inteligence. Argo, Dokořán, 2020. ISBN 978-80-7363-948-8.

Tip ke zhlédnutí

Rozhovory s experty o různých oblastech souvisejících s umělou inteligencí – Educast AI dětem. Aidetem.cz [online]. [cit. 4. června 2025]. Dostupné z: https://aidetem.cz/educast/

Tipy k poslechu

Rozpravy 2025/05 na téma „AI v médiích“, kde se dozvíte, jak se používá AI v českých médiích a jakým výzvám v této souvislosti česká média a novináři čelí. Veškeré informace k tomuto dílu i odkazy k poslechu jsou dostupné zde: https://rozpravy.fsv.cuni.cz/r2025-05-ai-v-mediich/

Mediální minimum o manipulacích s informacemi s Dominikem Voráčem, kde se dozvíte, jak se informacemi manipulovalo před rozšířením generativní AI a jak to probíhá v současnosti – veškeré informace k tomuto dílu i odkazy k poslechu jsou dostupné zde: https://rozpravy.fsv.cuni.cz/jak-na-manipulace-s-informacemi-v-ere-ai-s-dominikem-voracem/

Mediální minimum o ověřování informací s Janou Magdoňovou, kde se dozvíte, jak informace ověřovat, jaké nástroje se k tomu dají použít a jak se dá odhalit manipulativní fotografie či video – veškeré informace k tomuto dílu i odkazy k poslechu jsou dostupné zde: https://rozpravy.fsv.cuni.cz/mm6-jak-overovat-informace-s-janou-magdonovou/

SLÍŽEK, D. Mohou se AI modely bránit vypnutí? Koubský: Nemají vůli. Když jim logika nestačí, chovají se náhodně. Plus.rozhlas.cz [online]. 2025-05-30 [cit. 6. června 2025]. Dostupné z: https://plus.rozhlas.cz/mohou-se-ai-modely-branit-vypnuti-koubsky-nemaji-vuli-kdyz-jim-logika-nestaci-9484513